Ученые научили нейросеть угадывать движение рук человека по его речи

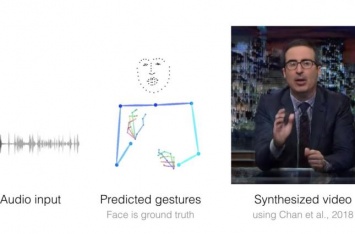

Ученые из Калифорнийского университета в Беркли создали алгоритм, который может угадать движение рук человека по его речи. Как сообщает N+1, для этого нейросеть изучает только аудиозапись речи, затем создает анимированную модель тела человека, а потом на ее основе генерирует реалистичный видеоролик.

Отмечается, что работу алгоритма можно разбить на две части: сначала он предсказывает движение рук по аудиозаписи речи, а затем визуализирует предсказанные жесты с помощью алгоритма, который разработала в 2018 году смежная группа исследователей.

На первом этапе алгоритм на базе сверточной нейросети UNet принимает двумерную спектрограмму аудиозаписи и превращает ее в одномерный промежуточный сигнал. Затем этот сигнал превращается в последовательность поз, представленных в виде скелетной модели с 49 ключевыми точками, отражающими части рук, плеч и шеи. После этого последовательность поз передается алгоритму визуализации, который превращает ее в видеоролик.

Для обучения алгоритма ученые собрали базу данных, которая состояла из записей суммарной длительностью 144 часа. В частности, она содержала записи речей телеведущих, лекторов и проповедников. С помощью алгоритма OpenPose исследователи сопоставили каждому кадру из датасета скелетную модель. Получая во время обучения записи речи и кадры с готовой моделью, алгоритм научился создавать реалистичные видеоролики.