Что такое Project Soli от Google и почему он переоценен

Если вы следите за миром мобильных технологий (а лучший способ это делать - быть подписанным на наш Телеграм-канал), то вы должны знать, что у компании Google есть масса наработок, которые они тестируют какое-то время, а затем применяют (или не применят) в своих продуктах. Одним из таких проектов является Project Soli, первые упоминания о котором можно найти аж в 2015 году. Он призван произвести революцию в сфере взаимодействия пользователя с телефоном и появится в грядущем Pixel 4. Но так ли Project Soli хорош на самом деле?

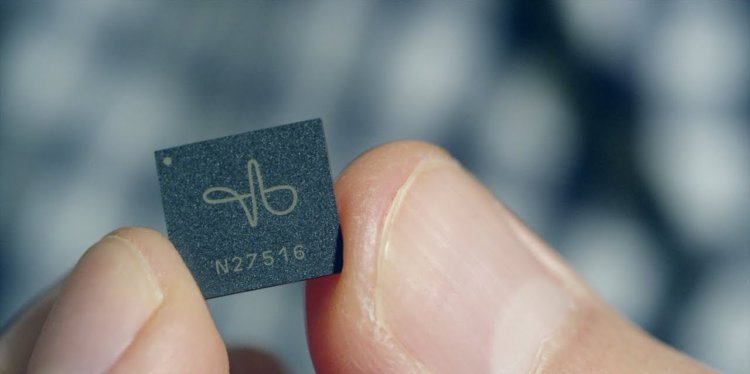

Что такое Project Soli

Project Soli - это миниатюрный сенсор, который может отслеживать движения рук и пальцев в пространстве, которые затем анализируются и считываются устройством, превращаясь в команды для гаджета. Работает Project Soli на радиочастотах и по факту своим принципом действия он очень близок к радарам. Только в миниатюре. На бумаге использование миниатюрного, чувствительного к движению руки радара в смартфоне кажется чем-то невероятным. Можно будет, словно джедай, взмахами руки управлять смартфоном. Но так ли это круто и полезно на самом деле?

На что способен Project Soli и почему он может оказаться никому не нужен

Согласно пресс-релизу Google, пользователи Pixel 4, который, напомним, получит Project Soli в качестве одной из фич, смогут "пропускать песни, отключать будильник и принимать телефонные звонки взмахом руки". Круто? Круто! Но, прежде чем использовать вышеупомянутые жесты, вам нужно будет закрепить устройство так, чтобы экран "смотрел" на вас или взять смартфон в другую руку, так как Project Soli направляет радиосигнал в определенном направлении. То есть просто так махать руками и использовать Силу у вас не выйдет.

При этом страница Project Soli от компании Google демонстрирует возможность использования "микрорадара" в смарт-часах и браслетах. И вот тут уже подобная технология может быть оправдана, ведь из-за крайне ограниченного места на экране и на самом гаджете набор опций и элементов управления сильно стеснен из-за форм-фактора. Project Soli и подобные сенсоры могли бы прийти на помощь, дав пользователям куда больший контроль над умными устройствами. Однако же на данный момент точных сведений об умных часах от Google (а также о том, будут ли использоваться в них наработки Project Soli) нет.

Стоит заметить, что не только Google стремится разработать новые способы взаимодействия. Samsung и LG пытались внедрить системы взаимодействия на основе жестов на протяжении многих лет. Samsung впервые представила жесты на Galaxy S4 в 2013 году. Используя фронтальную камеру устройства, гаджет распознавал определенные жесты рук и выполнял ряд задач. Почему же мы не слышим об этой технологии сейчас? Потому что практически сразу же корейцы отказались от использования таких жестов в своих аппаратах серии Galaxy S, признав эксперимент неудачным. LG в этом году вернула "бесконтактное взаимодействие" в LG G8 ThinQ. Используя фронтальную камеру телефона, текущий флагман LG, на бумаге, может выполнять определенные задачи. Однако система жестов не была положительно воспринята рецензентами, которые заклеймили подход LG как "неинтуитивный".

Если подумать, то Google наступает на те же грабли. Использование жестов на данный момент довольно сильно ограничено по своей функциональности, а также по самому принципу взаимодействия. Нужно "махать руками" под определенным углом к телефону и так далее. Мы не говорим, что не стоит пытаться сделать что-то, если до этого у кого-то подобное не получалось. Просто нужно учиться не только на своих ошибках, но и на чужих. А этого не происходит. Но мы были бы рады ошибаться, ведь очень хочется технологических прорывов, а не очередных флагманов "с мегапикселями и мегагерцами".