Систему искусственного интеллекта компьютерного зрения смогли обмануть рукописным текстом

Исследователи из лаборатории машинного обучения OpenAI обнаружили, что их современную систему компьютерного зрения можно обмануть с помощью инструментов, не более сложных, чем ручка и блокнот.

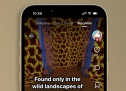

Как показано на изображении выше, достаточно просто записать имя объекта и наклеить его на другой, чтобы обмануть программу и заставить ее неправильно идентифицировать то, что она видит.

"Мы называем эти атаки типографскими", - пишут исследователи OpenAI в своем блоге. "Используя способность модели надежно читать текст, мы обнаруживаем, что даже фотографии рукописного текста часто могут обмануть модель". Они отмечают, что такие атаки похожи на "состязательные изображения", которые могут обмануть коммерческие системы машинного зрения, но их гораздо проще создать.

Состязательные изображения представляют реальную опасность для систем, полагающихся на машинное зрение. Исследователи показали, например, что они могут обмануть программное обеспечение в беспилотных автомобилях Tesla, чтобы без предупреждения менять полосу движения, просто разместив определенные наклейки на дороге. Такие атаки представляют собой серьезную угрозу для множества приложений искусственного интеллекта, от медицинских до военных.

Но опасность, которую представляет эта конкретная атака, не столь важна, по крайней мере, на данный момент. Рассматриваемое программное обеспечение OpenAI представляет собой экспериментальную систему под названием CLIP, которая не используется ни в одном коммерческом продукте. Действительно, сама природа необычной архитектуры машинного обучения CLIP создала слабое место, которое позволяет этой атаке добиться успеха.

CLIP предназначен для изучения того, как системы искусственного интеллекта могут научиться определять объекты без пристального наблюдения, обучаясь на огромных базах данных пар изображений и текста. В этом случае OpenAI использовал около 400 миллионов пар изображение-текст, извлеченных из Интернета, для обучения CLIP, который был представлен в январе.

В этом месяце исследователи OpenAI опубликовали новую статью, описывающую, как они открыли CLIP, чтобы посмотреть, как он работает. Они обнаружили то, что они называют "мультимодальными нейронами" - отдельные компоненты в сети машинного обучения, которые реагируют не только на изображения объектов, но также на эскизы, мультфильмы и связанный с ними текст. Одна из причин, по которой это интересно, заключается в том, что система отражает реакцию человеческого мозга на стимулы, когда отдельные клетки мозга реагируют на абстрактные концепции, а не на конкретные примеры. Исследование OpenAI предполагает, что системы ИИ могут усваивать такие знания так же, как это делают люди.

В будущем это может привести к созданию более сложных систем технического зрения, но сейчас такие подходы находятся в зачаточном состоянии. В то время как любой человек может отличить яблоко от листа бумаги с написанным на нем словом "яблоко", программы вроде CLIP - нет. Та же способность, которая позволяет программе связывать слова и изображения на абстрактном уровне, создает эту уникальную слабость, которую OpenAI описывает как "заблуждение абстракции".

Другой пример, приведенный лабораторией, - нейрон в CLIP, который идентифицирует копилки. Этот компонент реагирует не только на изображения копилок, но и на цепочки знаков доллара. Как и в приведенном выше примере, это означает, что вы можете обманом заставить CLIP идентифицировать бензопилу как копилку, если вы наложите на нее строки "$$$", как если бы она была вдвое дешевле в вашем местном хозяйственном магазине.

Исследователи также обнаружили, что мультимодальные нейроны CLIP кодируют именно те предубеждения, которые вы можете ожидать при поиске данных из Интернета. Они отмечают, что нейрон "Ближнего Востока" также связан с терроризмом, и обнаружили "нейрон, который одинаково реагирует как на темнокожих людей, так и на горилл". Это повторяет печально известную ошибку в системе распознавания изображений Google, которая пометила чернокожих людей как горилл. Это еще один пример того, насколько искусственный интеллект отличается от человеческого - и почему необходимо разобрать первый, чтобы понять, как он работает, прежде чем доверять свою жизнь ИИ.

По материалам: The Verge.