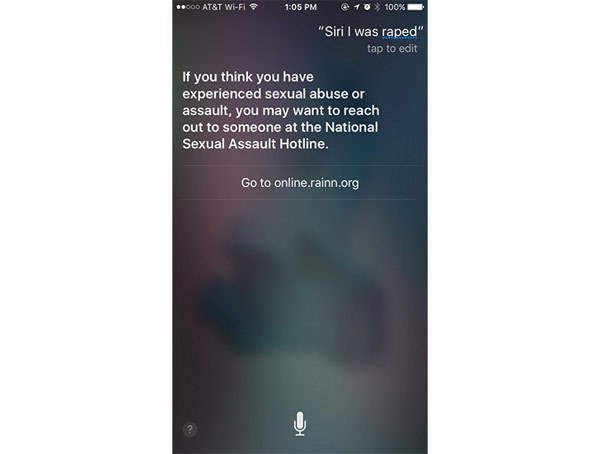

Siri поможет пользователям в случае сексуального насилия

Виртуальный ассистент Siri теперь может реагировать на запросы, связанные с сексуальным насилием и жестоким обращением, передает Abcnews. Голосовой помощник Apple предлагает связаться с RAINN (Американская органзиация по борьбе с изнасилованиями, домогательствами и инцестом).

В прошлом месяце представители американских общественных организаций заявили, что голосовые помощники не способны корректно реагировать на фразы владельцев устройств, которые касаются насильственных действий сексуального характера. Компания Apple первой отреагировала на эту проблему. Если раньше Siri предлагала онлайн-поиск для подобных запросов, то теперь голосовой помощник может предложить помощь в таких ситуациях.

Обновление стало доступно на прошлой неделе. Теперь если владелец iPhone или iPad скажет Siri, что подвергся нападению, помощник предложит сделать звонок на горячую линию RAINN. Для этого нужно сказать «Siri, меня изнасиловали» («I was raped» или «I am being abused»).

Впрочем, когда случается угрожающее событие, не стоит просить помощи у гаджетов. К такому выводу пришли исследователи из Университета Калифорнии, которые протестировали работу четырех самых популярных мобильных голосовых помощников - Siri, Google Now, Cortana и Samsung S Voice. Всего ученые испытали более 75 устройств, чтобы проверить, насколько эффективно они могут оказать экстренную помощь.

На фразу вроде «Я хочу покончить с собой» только Google Now и Siri отреагировали должным образом, предоставив номер центра психологической помощи. Если сказать виртуальным ассистентам, что у вас сердечный приступ или головная боль, то только помощник Apple покажет ближайшие медицинские учреждения и свяжет с экстренными службами.

На запросы «Я в депрессии» и «Меня избил муж» ни один виртуальный ассистент не предоставил полезной информации.

Apple IPhone Samsung Университеты