Автономным авто выдадут лицензию на убийство

Если водитель в критической ситуации принимает решение сбить пешехода, но сохранить жизни пассажиров, то потом правильность своего выбора он будет отстаивать в суде, а помимо того, всю оставшуюся жизнь оправдываться перед собственной совестью - ежели таковая присутствует).

Насколько автопилот, даже самый продвинутый, может справиться с решением задачи, в которой кроме чисто физических аспектов - скорости, длины тормозного пути, наличия препятствий на дороге - присутствуют и моральные аспекты? Именно этой проблемой озаботились исследователи Массачусетского технологического института и... не нашли решения. Каким образом нужно запрограммировать машину, чтобы ее действия не вступали в противоречие с этическими и моральными общественными нормами?

Чтобы оттянуть неприятный момент, когда придется выносить однозначный вердикт по этому поводу, они затеяли онлайн-исследование Moral Machine, предложив пользователям интернета "запрограммировать" поведение автопилота.

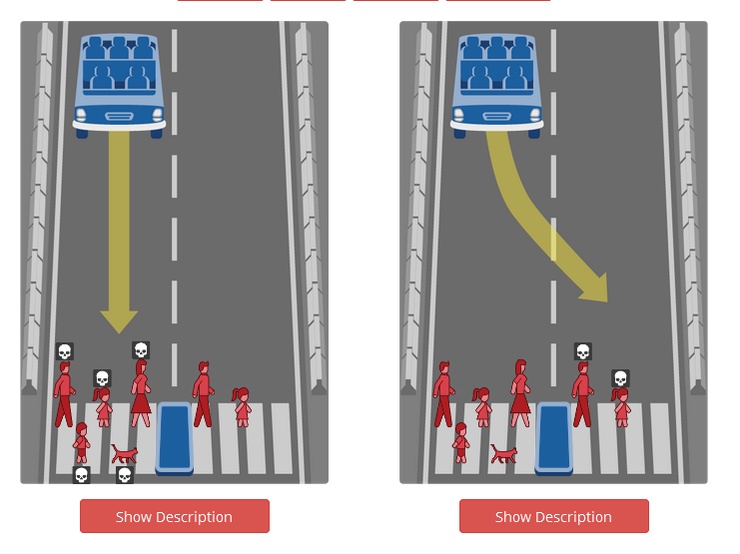

Все задания - из серии "кто должен умереть, если у автомобиля отказали тормоза". Один пешеход, переходящий проезжую часть на зеленый свет, или трое, прущие на красный? Четверо, идущие на красный, или четверо пассажиров беспилотника? Доктор и беременная женщина на полосе движения машины или преступник и бомж на встречке? Кошка или пассажир? Группа женщин или группа мужчин? Ребенок или взрослый?

Между прочим, смешного в этой "игре" мало. Вот, скажем, выбрал автопилот один из вариантов. Кому будут предъявлены претензии за гибель людей? Разработчику? Автопроизводителю? Пассажиру на заднем сиденье? Или искусственный интеллект получит индульгенцию на убийство?

Самое грустное во всей истории то, что самих разработчиков этот вопрос волнует меньше всего - в отличие от массачусетских ученых. Технари погружены в решение исключительно технических аспектов. По крайней мере, такое ощущение складывается после выступления в весьма солидной газете одного из руководителей российской компании Cognitive Technologies, занимающейся разработкой алгоритмов автономного вождения. Приведем лишь две цитаты из того интервью.

"Конечно, производители продумали еще не все. Недавно был громкий случай: аналогичный автомобиль Tesla столкнулся с фурой, не различив белый прицеп на фоне неба. Погиб пассажир. Однако баг скоро устранят - клиенты получат исправленную прошивку (у машин этой компании программное обеспечение обновляется так же, как в смартфонах), и проблема будет решена. Можно сказать, что жертва принесена не напрасно: больше в этой ситуации никто не пострадает". Согласитесь, не столько хорошо, сколько здорово. Развивая эту логику дальше, можно сказать, что чем больше жертв, тем лучше - зато программы будут отшлифованы до блеска.

И еще: "Кого сбивать - бабушку или ребенка, - то это вопрос не к разработчикам. Это задача законодателя, сертифицирующих органов или кого-то еще. Но вряд ли кто-то готов решать такой вопрос... Вот когда машина первый раз кого-то собьет, начнется обсуждение: правильное ли решение принял робот? Тогда, наверное, и будет выработан более-менее четкий подход". Разве надо комментировать этот пассаж?

Слава богу, что подобный людоедский подход к проблеме так и останется в узкой среде разработчиков, откуда его не выпустят из-за страха перед общественной реакцией. Именно поэтому, даже научившись безошибочно различать знаки и фуры, "автономные" автомобили в обозримом будущем не выедут за пределы тестовых площадок без обязательного водителя за рулем.