Как я пробовал написать статью голосовым вводом, и что из этого получилось

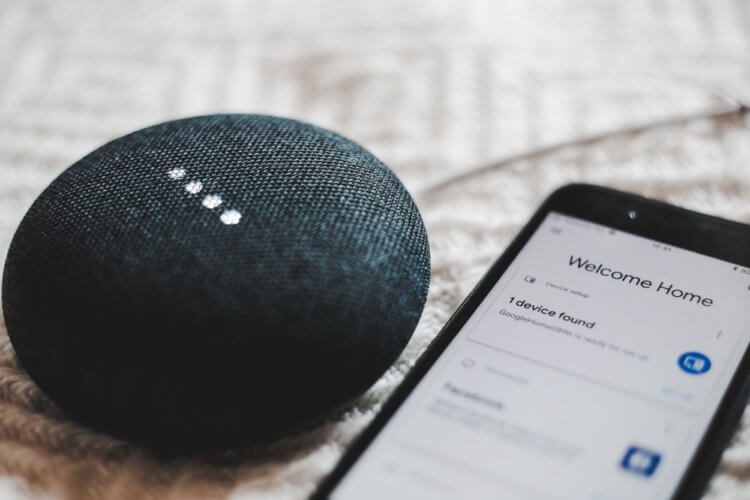

Смартфоны уже давно стали чем-то большим, чем просто телефоны. Мы каждый день используем наш гаджет для переписки с друзьями, просмотра видеороликов на YouTube, общения в Telegram, и при этом сегодня телефон для многих может стать заменой полноценного компьютера. Я не шучу, на своем примере я готов показать, как нейронные сети от Google способны за меня писать статью. До недавнего времени я скептически относился к голосовому вводу, который встроен в клавиатуру gBoard, однако я решил попробовать и крайне удивился тому, насколько качественно клавиатура способна распознавать мою речь. В данном материале мы рассмотрим, как же компании удалось создать настолько качественное распознавание речи, и как при этом данная функция может помочь нам в работе.

Все это время я писал статьи с помощью своего ноутбука или PC. Мне всегда выражать свои мысли с помощью голоса было легче, чем с помощью пальцев рук. Это делает процесс выражения мыслей более естественным, более плавным (good flow) и более быстрым. Ввод с помощью клавиатуры очень часто приводил к ситуациям, когда я терял ход мыслей. Уже сейчас я готов опубликовать вторую статью продиктованную своему телефону, ну и мне не обязательно при этом обладать быстрой слепой десятипальцевой печатью (хочу отметить, что печатаю я неплохо). Возможность написания материала голосом вызывает у меня ощущение радости от того, насколько сильно продвинулись технологии вперед. Если раньше я мог писать материал за час-два своего времени, сейчас мне удается уменьшить эти показатели в 2 раза просто потому, что выражение мыслей голосом происходит быстрее, чем с помощью набора текста.

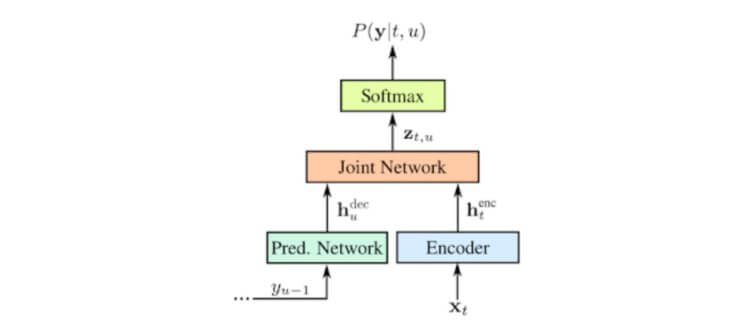

Я изучил, как работает голосовой ввод gBoard и, по правде говоря, был удивлен. Ранее компания использовала достаточно старые способы распознавания речи, они были основаны на модели Gaussian Mixture Model. Данная модель использовалась в течение 30 лет. Однако все изменилось в 2012 году, когда начали становиться популярными нейронные сети. Конечно, они существовали и раньше, однако именно с 2012 года начался новый этап в развитии. Стали использоваться глубокие нейронные сети, рекуррентные и другие. И именно последний типы нейронных сетей лежит в основе технологии распознавания голоса. В настоящее время Google использует архитектуру нейронных сетей Recurrent Neural Network Transducers (RNN-T) для распознавания речи. А уже сейчас обладатели смартфонов Pixel могут использовать голосовой ввод gBoard без Интернета. Этого удалось добиться несколько этапами оптимизации, одним из которых стала финальная компрессия, благодаря чему размер изначальной модели с 2 гигабайт сократился до 80 мегабайт. Предлагаю обсудить это в Телеграм.

В традиционных системах распознавания речи существуют несколько компонентов: модель, которая разбивает аудио на части длинной в 10 миллисекунд - их называют фонемами, модель произношения, которая соединяет фонемы вместе, образуя слова, а также языковая модель, которая предлагает пользователю готовые фразы. В ранних системах данные компоненты работали независимо друг от друга. Примерно в 2014 году исследователи начали фокусироваться на тренировке общей нейронной сети, чтобы на вход подать один аудиофайл, а на выходе получить готовое предложение. Такой sequence-to-sequence способ позволил сделать распознавание более точным, однако он работал лишь после полного ввода предложения. Между тем существовала технология CTC, она позволила уменьшить задержку в распознавании, на тот момент это стало серьезным шагом на пути к созданию рекуррентных нейронных сетей с преобразователями RNN-T. С этого момента стало возможным точное распознавание в момент непосредственного ввода речи.

Какие выводы можно сделать из всего этого? Безусловно, уже сейчас можно использовать голосовой ввод для точного распознавания русского текста, и раньше так хорошо он не работал. Пока, к сожалению, нейросеть не способна понимать, где ставить пунктуационные символы, однако само распознавание достаточно точное, что внушает надежду на то, что в будущем нам предложат еще больше возможностей. Не исключаю, что уже в ближайшие два года Google адаптирует свою новую нейросеть для работы с русским языком в оффлайн-режиме. Пока же мы будем довольствоваться тем, что имеем.

Делитесь мнением в комментариях с помощью языкового ввода.